AI事業

02

AI事業

AIデータセンターで採用されているGPUは非常に大きな電力を消費する。このため日本では地球温暖化対策に逆行して、火力発電所を多数建設する必要がある。GoogleはAIデータセンターのために複数の原子力発電所を建設するという。消費電力を減らすためNPUというAIに特化したLSIが多数開発されているが、これらの消費電力はNVIDIA GPUの 1/3 ~ 1/5の消費電力であり、これでは根本的な解決にはならない。 FloadiaのCiMはNVIDIA GPUの 1/1000 消費電力、コストは1/10以下でAI計算が実行できる。FloadiaのCiMが最終的な解決策となる。

・コストは1/10以下 (NVIDIA BG200は約700万円)

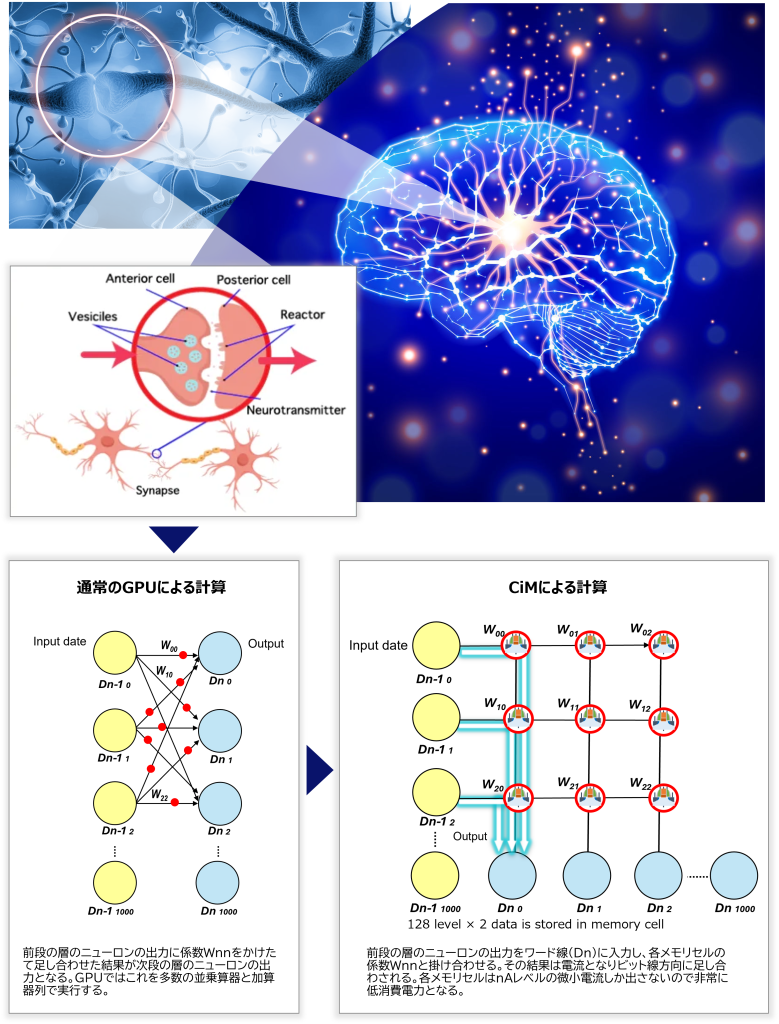

CiM(Computing in Memory)の原理 -アナログ回路的に計算を行う-

CiMではGPUによる大規模なデジタル回路でニューラルネットワークの積和演算を行うのと異なり、フラッシュメモリの各メモリセルに保持された係数とワード線から印加されたアナログ入力で生成された電流をビット線上で加算して計算を行う。非常にシンプルで超低消費電力(NVIDIA GPUの1/1000)かつ低コストが実現できる。世界にはフローディア以外にも数社が同様のCiMを開発していますが、低消費電力性能と計算精度でフローディアと同等以上の性能を実現できている会社はありません。アナログ計算には誤差が含まれますが、ニューラルネットワークには人間の脳のように誤差をキャンセルする仕組みが備わっています。

CiMターゲットアプリケーション

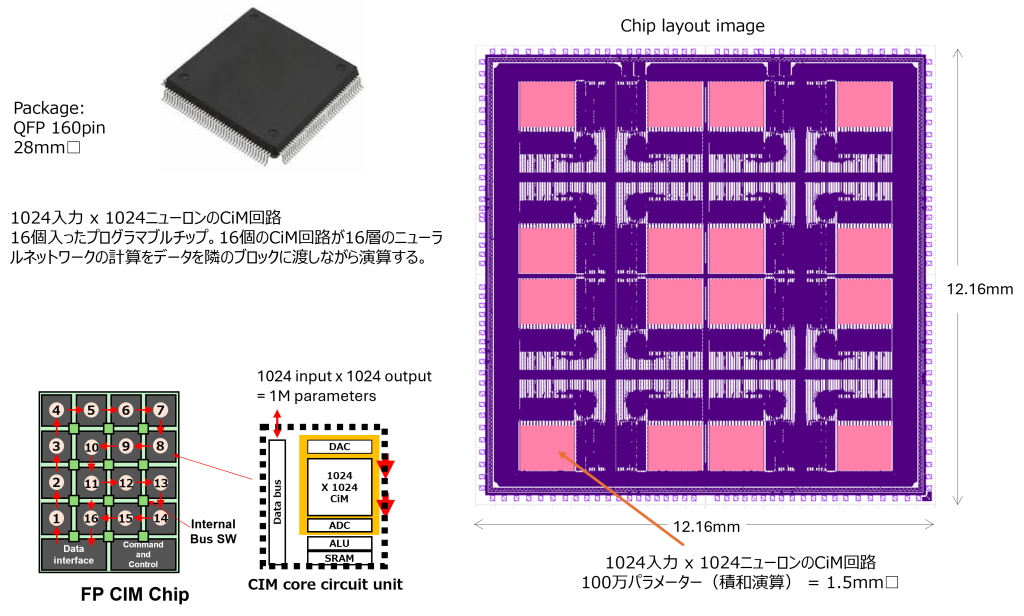

FP-CiM 16 Layer テストチップ

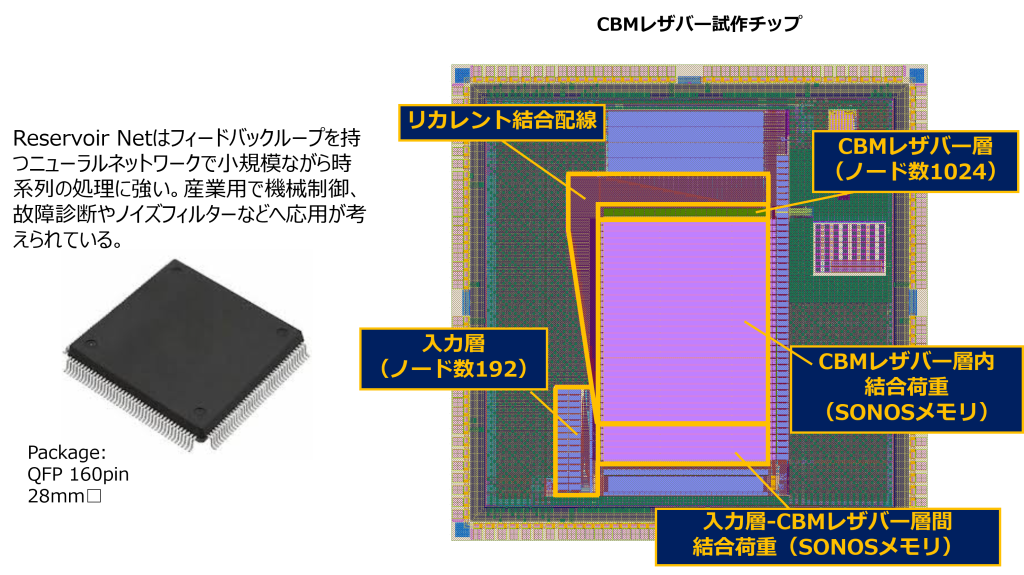

CBM Reservoir Net テストチップブロック図

AI

- 画像認識

- 音声認識

- センサーデータからアノマリー検出スマートセンサー

AI Edge computing

- リアルタイム

- セキュリティ+プライバシー

- クラウド負荷軽減・超低消費電力での AI演算

Computing in Memoryの原理

Why Floadia?

- 競合比100倍以上の電力効率(圧倒的なTOPS/Wを実現)

- 低コスト(40nm〜130nmのプロセスノードでのデバイス生産)

![株式会社フローディア [Floadia]](https://floadia.com/jp/wp-content/themes/floadia/assets/images/floadia.svg)